Wie Nvidias neue Kontext-GPU millionenlange Eingaben, generative Videos und „Coding-Agents“ beschleunigt

Mit Rubin CPX führt Nvidia eine völlig neue Kategorie von Beschleunigern ein, die nicht primär die Modellgewichte eines KI-Systems antreiben, sondern den bislang teuersten Flaschenhals im Inferenzpfad gezielt aushebeln: die Verarbeitung extrem langer Kontexte. Gemeint sind Workloads, bei denen große Sprach- und Multimodalmodelle Millionen Tokens auf einmal „vorverdauen“ müssen – etwa eine Stunde Videomaterial, umfangreiche Codebasen, lange Gesprächsverläufe oder mehrstündige Meetings. Rubin CPX setzt genau hier an und bündelt Video-Decoding, -Encoding und die kontextuelle Vorverarbeitung direkt im Chip, um generative Video-Anwendungen und KI-gestützte Softwareentwicklung spürbar schneller und günstiger zu machen. Nvidia spricht von einer speziellen, auf Langkontext optimierten GPU-Klasse innerhalb der kommenden Rubin-Generation, die die Blackwell-Ära ablösen soll und ab Ende 2026 allgemein verfügbar sein wird.

Warum „Kontextverarbeitung“ der neue Engpass ist

In der Praxis entfällt bei langen Sequenzen ein großer Teil der Inferenzzeit nicht auf das eigentliche Token-Sampling, sondern auf die aufwändige Vorarbeit: Videos müssen effizient zerlegt und semantisch aufbereitet, Text- und Codefenster mit Hunderttausenden bis Millionen Tokens in Vektorräume projiziert, Attention-Matrizen vorbereitet und Zwischenergebnisse in Hochgeschwindigkeit zwischen Speicher, Recheneinheiten und Netzwerk verschoben werden. Klassische GPU-Setups geraten dabei in eine ungünstige Ressourcenmischung: Einerseits fehlt es an „billiger“ Bandbreite für das serielle Schaufeln riesiger Datenfenster, andererseits sind spezialisierte Funktionsblöcke für Medienströme oft nicht auf Langformat-Generierung ausgelegt. Rubin CPX attackiert genau diese Mischlast, indem es die „Prefill“-Phase – also die massive Kontextaufnahme – mit dedizierten Pfaden und Einheiten beschleunigt, bevor anschließend die eigentliche Text-, Bild- oder Videogenerierung auf klassischen Rubin-GPUs (R100-Familie) weiterläuft. Das folgt Nvidias Strategie der „disaggregierten Inferenz“: einzelne Aufgaben werden auf genau passende Chips ausgelagert, um Durchsatz und Effizienz auf Systemebene zu maximieren.

Die wichtigsten Spezifikationen im Überblick

Rubin CPX ist als monolithischer Chip ausgelegt, nutzt kosteneffizienten GDDR7-Speicher statt teurem HBM und bringt laut Nvidia bis zu 128 GB Kapazität mit. Für die eigentlichen Rechenoperationen verweist das Unternehmen auf bis zu 30 PFLOPS bei NVFP4-Präzision – ein auf Inferenz optimiertes 4-Bit-Format, das hohe Effizienz bei akzeptabler Genauigkeit ermöglicht. Das Design ist auf die Beschleunigung langer Kontexte und Mediendurchsätze fokussiert; Nvidia betont zudem dreifach schnellere Attention-Leistung im Vergleich zu aktuellen GB300-Systemen (Blackwell-Generation). Damit zielt Rubin CPX genau auf jene Engstellen, die bei millionenlangen Sequenzen bislang die Latenz hochtrieben und die TCO nach oben schoben.

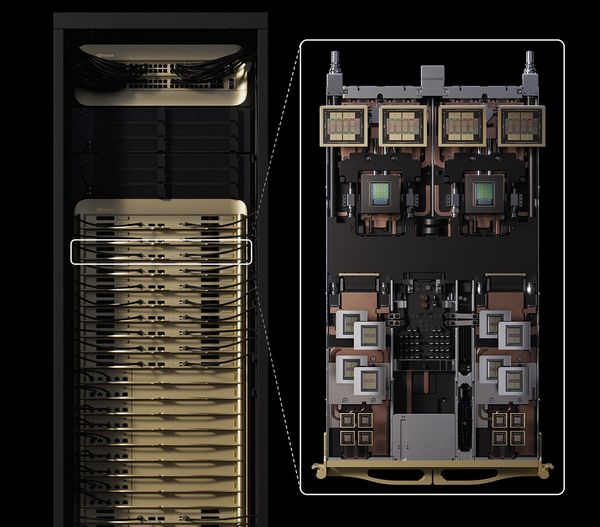

Von der Einzelkarte bis zum Rack: Vera Rubin NVL144 CPX

Auf Systemebene verankert Nvidia Rubin CPX in der neuen Plattform „Vera Rubin NVL144 CPX“. Der Name verrät es: In einem vollständigen Rack skaliert Nvidia auf 144 Einheiten und kombiniert CPX-Beschleuniger mit Rubin-GPUs und den neuen Arm-Server-CPUs der Vera-Familie. Das Ziel ist ein durchgehender Pfad – von der Videoaufnahme über die Kontextaufbereitung bis zur eigentlichen Generierung – ohne wiederholte, teure Kopierorgien zwischen heterogener Hardware. In Zahlen liest sich das so: Bis zu 8 Exaflops KI-Leistung (NVFP4), rund 100 TB „Fast Memory“ und 1,7 PB/s Speicherbandbreite in einem einzigen Rack; gegenüber der aktuellen GB300 NVL72-Generation spricht Nvidia von bis zu 7,5-facher Systemleistung und dreifach schnellerer Attention. Das ist nicht nur eine Rohzahl – schnellere Attention bei großem Kontext bedeutet vor allem, dass sehr lange Sequenzen ohne mühsame Chunking-Tricks und mit stabiler Latenz verarbeitet werden können.

Ökonomie des Langkontexts: Warum sich CPX für Betreiber rechnen soll

In Präsentationen und Briefings unterlegt Nvidia die technische Botschaft mit einer ökonomischen: Wer in der neuen Ära generativer Video-Anwendungen und komplexer Software-Agenten vorne mitspielen will, muss Inferenzkosten pro generiertem Token niedrig halten – gerade bei millionenlangen Kontexteingaben. Nvidia verknüpft dies mit einem aggressiven ROI-Narrativ: 100 Millionen US-Dollar Invest in Rubin-Systeme könnten – wohlgemerkt abhängig vom jeweiligen Geschäftsmodell – bis zu 5 Milliarden US-Dollar an „Token-Revenue“ anstoßen. Das ist keine harte Garantie, zeigt aber die Grundannahme: Wenn Langkontext günstig wird, eröffnen sich Produktkategorien wie semantische Video-Suche in vollminütigen Archiven, automatisierte Postproduktion, Enterprise-RAG über Firmendaten in bislang unpraktikablen Größenordnungen und „Coding Agents“, die nicht nur Dateien, sondern ganze Repos und Ticket-Historien im Blick behalten.

Warum GDDR7 statt HBM? Ein nüchterner Blick auf Kosten, Kapazität und Bandbreite

Dass Nvidia bei CPX auf GDDR7 setzt, ist strategisch: Für Langkontext-Workloads zählt große, bezahlbare Speicherkapazität mit hoher, aber nicht maximaler Bandbreite – genau die Nische, in der GDDR7 glänzt. HBM bleibt für dichte, bandbreitenhungrige Trainings- und Generierungsphasen unschlagbar, ist aber teurer und knapper. CPX kapselt die „breiten“ Vorarbeiten günstiger, ohne die kostbaren HBM-Ressourcen der Haupt-GPUs zu beanspruchen. In Summe ergibt sich eine Systemtopologie, die „teure“ und „kosteneffiziente“ Speicher-/Rechenschichten sinnvoll trennt, anstatt alles auf eine Allzweck-GPU zu zwingen.

Wo Rubin CPX den Unterschied macht: Konkrete Anwendungsbilder

Für Video-Teams bedeutet CPX, dass das volle Rohmaterial – etwa eine Stunde 4K-Footage – in einem Schuss semantisch „vorgekaut“ werden kann, bevor ein Generations-Modell Frames, Szenen, Übergänge oder Untertitel synthetisiert. Die Pipeline wird deterministischer, Latenzen sinken, und die Zahl der teuren Rückkopplungen zwischen Dekoder, Pre-/Postprocessing und Generator reduziert sich. In Data-/Product-Teams öffnet CPX RAG-Szenarien mit riesigen Dossiers, Compliance-Ordnern oder Wissensbasen, ohne sie in Dutzende Micro-Kontexte zu zerschneiden. Entwickler schließlich können Agenten aufbauen, die komplette Monorepos samt Historie, Issue-Tracker-Kontext, Logs und Architekturdiagramme erfassen und in einer Sitzung konsistent bearbeiten – je weniger Chunking und je stabiler die Attention, desto robuster wird das Verhalten der Agenten bei Refactorings und großen Codegen-Aufgaben. Dass Nvidia CPX im Marketing explizit für generatives Video und „AI-gestützte Softwareentwicklung“ positioniert, passt zu genau diesen Workloads.

Architekturgedanke „disaggregierte Inferenz“: Arbeitsteilung auf Systemebene

Die Leitidee hinter Rubin CPX ist, die Inferenz in wohldefinierte Phasen zu zerlegen und jeder Phase den optimalen Beschleuniger zuzuordnen. Während Rubin-GPUs (R100) mit viel HBM und Tensor-Durchsatz die eigentliche Generierung stemmen, kümmert sich CPX um Einlesen, Vorverarbeitung, Medienfluss und langen Kontext. Das senkt nicht nur Kosten pro Ergebnis, sondern entlastet das Netz: weniger Transfers zwischen unpassenden Einheiten, mehr Datenlokalität entlang einer Pipeline, die auf End-zu-End-Durchsatz ausgelegt ist. In großen Clustern spielt das eine doppelte Rolle – wer die Prefill-Lasten konsolidiert, hat downstream weniger „Backpressure“ und kann mehr Jobs pro Watt und pro 19-Zoll-Rack abwickeln.

Leistungsdaten im Kontext: 3× schnellere Attention und bis zu 7,5× Systemplus

Attention ist der Kernmechanismus, der Langkontext modellierbar macht – genau hier setzt CPX an. Nvidia nennt eine dreifach höhere Attention-Leistung gegenüber GB300 NVL72-Systemen; auf Rack-Ebene stellt die Vera Rubin NVL144 CPX-Plattform bis zu 7,5-fach mehr KI-Performance in Aussicht. Beides zielt auf die Realwelt-Hürden: nicht nur Spitzen-TFLOPS, sondern konsistente Latenzen im Langformat und eine Ökonomie, die millionenlange Fenster nicht zur betriebswirtschaftlichen Exotenübung macht.

Formfaktoren und Integration: Karten für bestehende Server, MGX-Baukasten für neue Racks

Nvidia plant Rubin CPX sowohl als Karte für etablierte Server-Designs als auch als Bestandteil modularer MGX-Racks. Das erleichtert zwei Pfade: Betreiber können bestehende Flotten schrittweise um CPX ergänzen – beispielsweise dedizierte Langkontext-Knoten in ihren Inferenz-Pods – oder sie setzen gleich auf komplette Vera-Rubin-Racks, wenn sie neue Rechenzentrumsflächen aufbauen. Für Anbieter, die heute schon Blackwell-Racks nutzen, ist insbesondere der NVL144-Pfad interessant, weil sich die Plattform-Semantik (Netz, Management, Software) weiterentwickelt, anstatt zu brechen.

Software-Stack und frühe Partner

Auf der Softwareseite bleibt es beim gewohnten Nvidia-Ökosystem: CUDA als Fundament, dazu Bibliotheken und Laufzeiten für LLM-/Multimodal-Inferenz, Compiler-Optimierungen und Medienpfade, die die CPX-Spezialisierung ausnutzen. In ersten Ankündigungen nennt Nvidia Unternehmen, die an frühen Integrationen arbeiten – darunter Cursor (Coding-Assistenz), Runway (Video-GenAI) und Magic (Agent-Workflows). Für diese Klassen von Anwendungen verspricht CPX nicht nur mehr Durchsatz, sondern vor allem planbare Latenz bei sehr langen Fenstern – die Voraussetzung, um aus Demos tragfähige Produkte zu schmieden.

Zeitplan und Einordnung gegenüber Blackwell

Rubin CPX ist Teil der nächsten Plattformgeneration nach Blackwell. Während Blackwell-Systeme Trainings- und Inferenzrekorde für „klassische“ Sequenzlängen gesetzt haben, positioniert Nvidia Rubin als Antwort auf die eskalierenden Kontextgrößen und Medienanforderungen. Allgemeine Verfügbarkeit stellt Nvidia für Ende 2026 in Aussicht – genug Zeit für Ökosystem und Betreiber, die passenden Workloads (Video, Agents, RAG in XXL) zu verdichten und den Wechsel technisch wie finanziell vorzubereiten. Wer heute Blackwell einsetzt, dürfte CPX zunächst als Ergänzung in gemischten Pods testen und später – wenn sich das ROI-Narrativ bewahrheitet – breiter ausrollen.

Fazit: Rubin CPX verschiebt den Engpass – und damit den Business Case für GenAI im Langformat

Die eigentliche Nachricht hinter Rubin CPX ist nicht eine weitere TFLOPS-Rekordmarke, sondern ein Perspektivwechsel: Inferenz wird als Kette spezialisierter Phasen gedacht, und die teuerste Phase – die Kontextaufnahme – bekommt ihren eigenen, kosteneffizienten Beschleuniger. Zusammen mit der Rack-Skalierung von Vera Rubin NVL144 CPX und dem klaren Fokus auf Video- und Coding-Workloads entsteht ein Plattform-Narrativ, das Betreiber adressiert, die generative Dienste mit langen Fenstern produktiv und profitabel betreiben wollen. Wer heute an Gen-Video, Code-Agenten oder extrem langen RAG-Pipelines arbeitet, sollte Rubin CPX auf die Roadmap setzen – nicht als Ersatz für Trainings-/Hochleistungs-GPUs, sondern als Baustein, der die Gesamtrechnung kippen kann.

Quellen & weiterführende Links

Reuters – „Nvidia unveils AI chips for video, software generation“

NVIDIA Developer Blog – „NVIDIA Rubin CPX Accelerates Inference Performance…“

GlobeNewswire – „NVIDIA Unveils Rubin CPX…“ (Pressemitteilung)

DataCenterDynamics – „Nvidia launches Rubin CPX GPU for large-scale inferencing“

Bloomberg – „Nvidia Unveils New Chip System for AI Video, Software Creation“

TechCrunch – „Nvidia unveils new GPU designed for long-context inference“

SDxCentral – „Nvidia Rubin CPX GPU powers intense AI workloads…“

CRN – „Nvidia Packs ‘New Class Of GPU’ Inside Vera Rubin NVL144 CPX Platform“

NetworkWorld – „Nvidia rolls out new GPUs for AI inferencing, large workloads“

Investing.com – „Nvidia unveils Rubin CPX GPU for million-token AI processing“

VideoCardz – „NVIDIA Rubin CPX GPU to feature 128GB GDDR7 memory…“

Forbes – „Nvidia Announces Rubin CPX GPU To Speed Long-Context AI“

Letzte Aktualisierung am 5.02.2026 / Affiliate Links / Bilder von der Amazon Product Advertising API. Alle hier angezeigten Preise und Verfügbarkeiten gelten zum angegebenen Zeitpunkt der Einbindung und können sich jederzeit ändern. Der Preis und die Verfügbarkeit, die zum Kaufzeitpunkt auf Amazon.de angezeigt werden, sind maßgeblich. Als Amazon-Partner verdienen wir an qualifizierten Verkäufen.