Die KI-Gigafactory München – offiziell als Industrial AI Cloud angekündigt – soll Unternehmen in Deutschland leistungsfähige GPU-Rechenleistung aus einem modernisierten Rechenzentrum bei München bereitstellen. Zielgruppe sind Industrie, Mittelstand und öffentliche Hand, die ohne eigene Großinvestitionen auf Training und Inferenz für Anwendungen wie Qualitätsprüfung, Simulationen, Robotik oder domänenspezifische Sprachmodelle zugreifen wollen. Das Vorhaben ist mit rund 1 Milliarde Euro veranschlagt und adressiert ein zentrales Nadelöhr der digitalen Transformation: verlässliche, lokal betriebene KI-Kapazitäten mit klaren Vorgaben zu Datenschutz, Compliance und Verfügbarkeit.

Politisch wird das Projekt als Signal für technologische Souveränität gelesen – fachlich entscheidend sind die harten Eckdaten: der Standort München, die geplante Inbetriebnahme Anfang 2026, das Zusammenspiel aus Betreiber, Hardware und Software-Stack sowie die Anbindung an industrielle Prozesse. So entsteht eine Infrastruktur, die speziell auf produktionsnahe Workloads und streng regulierte Branchen ausgelegt ist – von der Automobilfertigung über Chemie bis Medizintechnik.

Investition, Technik und Zeitplan

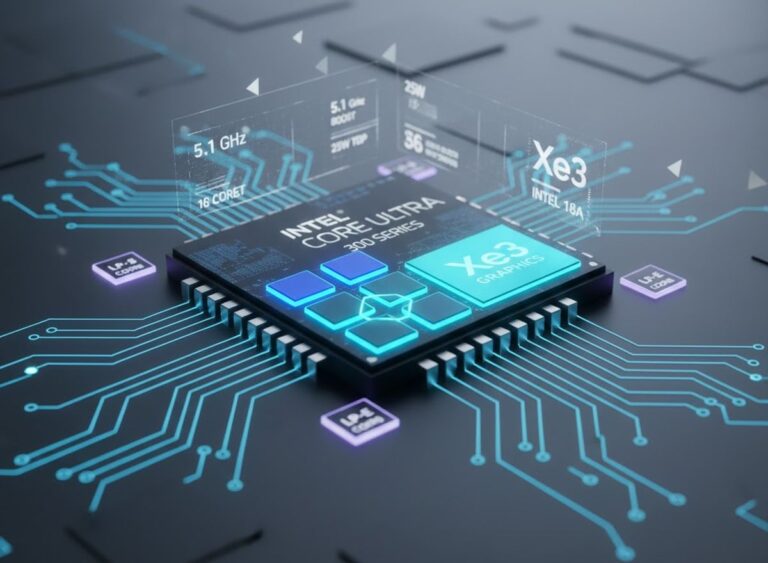

Die Betreiber nennen einen ambitionierten Fahrplan: Der Start der Industrial AI Cloud ist für das erste Quartal 2026 terminiert. Die Ausführung setzt auf moderne GPU-Server der Nvidia-Generation Blackwell und eine Energieversorgung, die perspektivisch vollständig aus erneuerbaren Quellen kommen soll. Berichtet wird außerdem von einer Ausstattung mit rund 1.000 DGX-B200-Systemen und einem Betrieb in einem umfassend modernisierten Rechenzentrum im Raum München. Damit liegt eine klare technische Linie vor, die bei Erfolg modular ausbaufähig ist – von zusätzlichen GPU-Kapazitäten bis zu neuen Branchenpaketen und Partnerintegrationen.

Wirtschaftlich ist der Ansatz relevant, weil Unternehmen die hohen Vorlaufkosten eigener Cluster vermeiden können. Statt langfristig Kapital zu binden, lassen sich Trainings- und Inferenzlasten flexibel buchen. Das senkt das Risiko in frühen Projektphasen, beschleunigt Proof-of-Concepts und schafft Planungssicherheit, wenn Pilotprojekte in den Regelbetrieb übergehen. Gleichzeitig verkürzt der Standort in Süddeutschland Datenwege aus Fabriken und Laboren – ein Vorteil für Latenz, Datensouveränität und Integrationsaufwand.

Warum der Standort München strategisch ist

Der Großraum München bündelt Forschung, Hightech-Industrie und Software-Ökosysteme auf engem Raum. Gerade für datenintensive Workflows – digitale Zwillinge, simulationsgetriebene Entwicklung, visuelle Qualitätskontrolle – zählt nicht nur rohe Rechenleistung, sondern die Nähe zu Produktionsdaten, Netzwerkanbindung und die Integration in bestehende IT-Landschaften. Hinzu kommen deutsche und europäische Compliance-Anforderungen, die in sensiblen Branchen (z. B. Automotive oder Gesundheitswesen) den Ausschlag für lokale Angebote geben können.

Auch energieseitig wird die Skalierung zur Kernfrage. Große GPU-Cluster verlangen hohe und planbare Leistungen aus dem Netz sowie effiziente Kühlung. Ein modernisiertes Rechenzentrum mit Fokus auf Effizienz und erneuerbare Energien erleichtert die Einhaltung von Nachhaltigkeitszielen – wichtig für Kunden, die ihre Scope-3-Emissionen im Blick haben und Audits bestehen müssen. Die Münchner Anlage kann hier, wenn sie wie angekündigt umgesetzt wird, als Referenzpunkt dienen.

KI-Gigafactory München im Kontext: USA–China GPU-Vergleich

Um die Größenordnung korrekt einzuordnen, lohnt der Blick auf die weltweite Verteilung aktueller KI-Rechenleistung. Nach jüngsten Datensätzen über GPU-Cluster entfällt auf die USA ungefähr drei Viertel der globalen GPU-Clusterleistung. China folgt mit deutlichem Abstand auf Rang zwei. Diese Verteilung spiegelt vor allem die massiven Investitionen der US-Hyperscaler wieder, die in kurzer Zeit eine Vielzahl an Clustern aufgebaut und ständig erweitert haben. Auch Europa wächst, bleibt im direkten Vergleich aber noch deutlich kleiner, was die Notwendigkeit gezielter, regionaler Ausbauten unterstreicht.

Wichtig für die Interpretation: Ein reiner „Anzahl-der-GPUs“-Vergleich greift fachlich zu kurz. GPUs unterscheiden sich drastisch in Architektur, Speicherausbau und Bandbreite; dazu kommen Cluster-Topologie, Netzwerk (z. B. NVLink/InfiniBand), Kühlung und Software-Stack. Für die Praxis zählt daher die Clusterleistung (also die effektiv abrufbare Rechenkapazität für Training und Inferenz) mehr als die bloße Stückzahl. Genau hier dominieren die USA – sowohl durch die Summe installierter Systeme als auch durch deren Modernität und Orchestrierung. China baut zwar kräftig aus, aber aus Sicht der weltweit verfügbaren Hochleistungs-Cluster bleibt der Abstand in der Performance-Spitze weiterhin groß.

Für die KI-Gigafactory München bedeutet das: Sie ist ein Baustein in einem größeren Bild. Im Vergleich zu gigantischen US-Clustern bleibt die Münchner Anlage kleiner, adressiert dafür aber gezielt die Bedarfe deutscher Unternehmen – mit lokalen SLAs, klaren Compliance-Leitplanken und direkter Anbindung an industrielle Prozesse. In Summe verbessert sie die regionale Versorgungslage und verkürzt die Zeit von der Idee bis zum produktiven Einsatz, ohne den Anspruch zu erheben, globale Hyperscaler-Dimensionen zu erreichen.

Was Unternehmen jetzt konkret erwartet

Für Anwender zählt am Ende die Umsetzbarkeit: Planbare Kapazitäten, transparente Preismodelle, zertifizierte Sicherheit und ein Portfolio vorkonfigurierter Branchenlösungen. Genau darauf zielt die Industrial AI Cloud ab: Zugang zu aktuellen GPU-Stacks, skalierbare Inferenz für produktionsnahe Workloads und Integrationspfade in bestehende ERP-, PLM- oder MES-Systeme. Unternehmen können so schrittweise vorgehen – mit kleinen, klar umrissenen Use-Cases starten, Datenpipelines stabilisieren und dann in größere Trainings- oder Fein-Tuning-Projekte wachsen.

Der entscheidende Vorteil einer regionalen Lösung liegt in der Kombination aus geringer Latenz, Datensouveränität und Industrie-Know-how. Wer sensible Konstruktionsdaten, Produktionsparameter oder Gesundheitsdaten verarbeitet, profitiert von klaren Rechtsrahmen und kurzen Wegen. Gelingt der Start pünktlich und werden Kapazitäten dynamisch erweitert, kann die Münchner Cloud in der Lieferkette der deutschen Industrie schnell zu einem strategischen Partner werden.

Fazit: Realistische Größenordnung, hoher praktischer Nutzen

Die KI-Gigafactory München setzt ein starkes Zeichen – weniger als Symbolpolitik, sondern als konkreter Ausbau deutscher KI-Infrastruktur mit erkennbaren Vorteilen für Unternehmen. Im globalen Maßstab bleibt die USA mit rund drei Vierteln der GPU-Clusterleistung klar führend, China folgt mit Abstand. Umso wichtiger sind verlässliche regionale Knoten, die performante Rechenleistung dort bereitstellen, wo Daten entstehen und Wertschöpfung stattfindet. Genau hier kann die Münchner Industrial AI Cloud ihre Wirkung entfalten: Sie schließt eine Lücke zwischen lokalen Anforderungen und globalen Maßstäben – und schafft eine Plattform, auf der industrielle KI-Projekte sicher, effizient und skalierbar wachsen können.

Quellen

- Deutsche Telekom partners with NVIDIA for AI cloud for Q1 2026 — Reuters (2025-11-04)

- Data on GPU Clusters — Epoch AI (2025-11-01)

Letzte Aktualisierung am 1.01.2026 / Affiliate Links / Bilder von der Amazon Product Advertising API. Alle hier angezeigten Preise und Verfügbarkeiten gelten zum angegebenen Zeitpunkt der Einbindung und können sich jederzeit ändern. Der Preis und die Verfügbarkeit, die zum Kaufzeitpunkt auf Amazon.de angezeigt werden, sind maßgeblich. Als Amazon-Partner verdienen wir an qualifizierten Verkäufen.